BSc: MathematicalFoundationsOfAI

Математические основы искуственного интеллекта

- Квалификация выпускника: бакалавр

- Направление подготовки: 09.03.01 - “Информатика и вычислительная техника”

- Направленность (профиль) образовательной программы: Математические основы ИИ

- Программу разработал(а):

1. Краткая характеристика дисциплины

Изучение дисциплины обеспечивает формирование и развитие компетенций обучающихся в следующих областях знаний:

Явление концентрации меры. Начиная с классических результатов Гаусса, Максвелла, Пуанкаре, Леви, Мильмана, планируется постепенно перейти к современным результатам и приложениям, в том числе, возникающим в разнообразных задачах анализа данных.

Численные методы решения задач (выпуклой) стохастической оптимизации в пространствах больших размеров. Такие задачи часто возникают в разнообразных приложениях, в том числе в анализе данных — принцип максимального правдоподобия в статистике, минимизация риска в машинном обучении.

Классическая теорема о SVD-разложении и ее различные обобщения будут продемонстрированы в приложениях к данным, хранящимся в многомерных массивах.

2. Перечень планируемых результатов обучения

- Целью освоения дисциплины является обучение студентов с соответствующей математикой, что впоследствии должно помочь им в изучении специализированных разделов анализа данных (машинного обучения, статистики, обучения с подкреплением, численных методов оптимизации, моделирования больших сетей и т.д.).

- Задачами дисциплины являются ...

Общая характеристика результата обучения по дисциплине

- Знания: после прохождения курса у студентов должны быть сформированы .

- Умения: сформированы умения .

- Навыки (владения): в результате прохождения курса формируются навыки .

3. Структура и содержание дисциплины

| № п/п |

Наименование раздела дисциплины |

Содержание дисциплины по темам |

| 1. | Вокруг задач поиска вектора PageRank. |

1 часть (Google problem) изложена в учебном пособии (Б. Вектор PageRank и Google Problem) |

| 2. | Элементы теории случайных процессов. |

1. Классические вопросы, связанные с методом Монте-Карло (вычисление площади, интеграла, Hit and run алгоритм).

2. Введение в эргодические динамические системы и эргодические случайные процессы (поворот окружности, сдвиг Бернулли, цепные дроби, восстановления с помощью эргодической теоремы параметра сноса по достаточно длинной траектории геометрического броуновского движения - процесса Башелье-Самуэльсона).

3. Основные классы случайных процессов (Мартингалы и безарбитражный рынок ценных бумаг, процессы Леви (Винеровский процесс как диффузионный предел случайных блужданий, Пуассоновский, сложный Пуассоновский), безгранично-делимые распределения).

|

| 3. | Вокруг Центральной предельной теоремы. |

1. Центральная предельная теорема для схемы i.i.d. и ее доказательство с помощью аппарата характеристических функций. Схема рассуждений была взята из книги Розанов Ю.А. Лекции по теории вероятностей. Изд. 3, 2008. 136 с. |

| 4. | Стохастические дифференциальные уравнения и методы Монте-Карло, Стохастический градиентный спуск. |

1. Условное математическое ожидание. Гильбертово пространство квадратично-интегрируемых случайных величин. Получение характеристической функции сложного Пуассоновского процесса с помощью формулы полного математического ожидания. Случайные процессы. под ред. А.В. Гасникова. |

| 5. | Вокруг стохастического градиентного спуска. |

1. Неравенство Азума-Хефдинга 3. Клиппирование, использование неравенства Бернштейна-Фридмана. |

| 6. | Концентрация меры. |

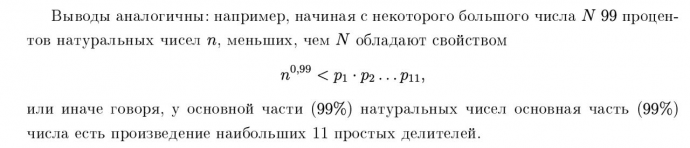

1. Метод Лапласа (исследование асимптотики интеграла по параметру), обоснование формулы Стирлинга.

2. Концентрация меры на сфере.

3. Случайные перестановки и их свойства

5. Неравенство Талаграна (просто упоминание)

6. Теорема Джонсона-Линденштраусса.

7. Вероятностная проверка тождеств.

|

| 7. | Большие системы (макросистемы). |

1. Теорема Клартага (только формулировка)

2. Предельные формы (диаграммы Юнга, Ричардсона, выпуклые ломаные)

3. Модели роста сетей (типа интернета) на принципе предпочтительного присоединения

4. Эволюция РНК и генетические алгоритмы

5. Время достижения ускоренного консенсуса снизу оценивается диаметром графа и квадрат этого времени отвечает времени выхода сопряженной марковской цепи на стационарное (инвариантное) распределение

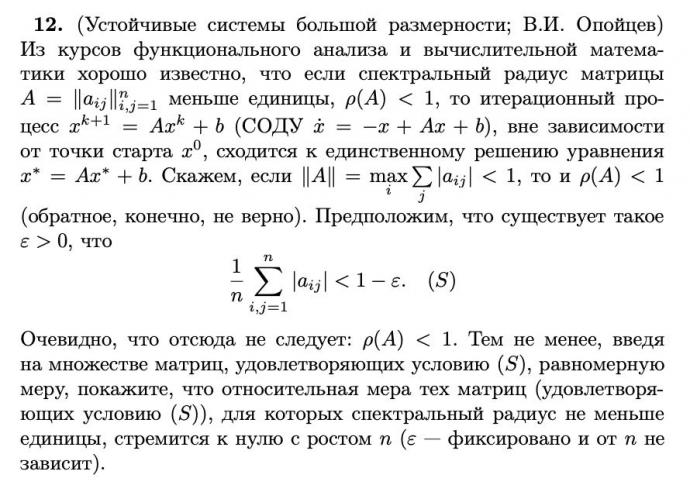

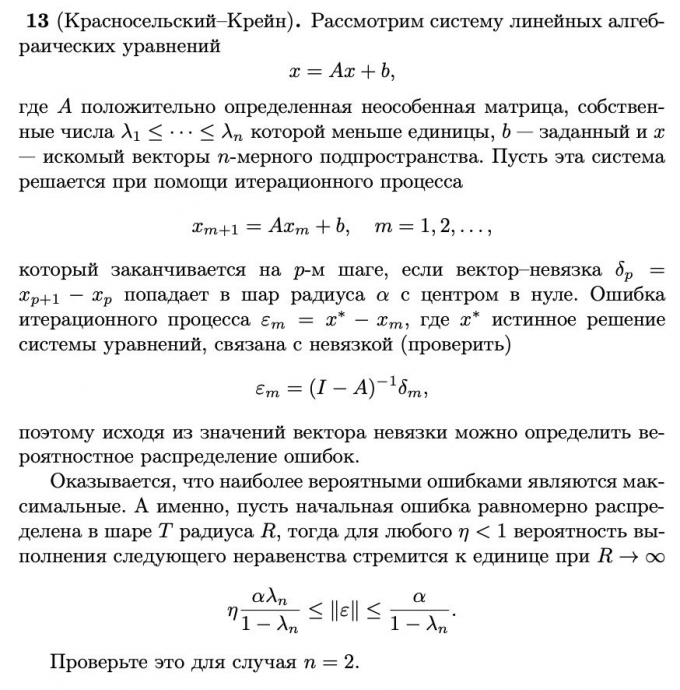

6. Распределение ошибок при решении систем линейных уравнений

7. Равновесия макросистем, как аттракторы в моделях стохастической химической кинетики. Пример «Кинетика социального неравенства»

8. Метод перевала. Элементы ТФКП. Формула Коши. Получение оценок больших уклонений (теорема Крамера) с помощью метода перевала.

9. Игрушечная модель эволюции Д. Кьялво - степенной закон распределения частоты лавин от длительности (связь с временем первого возвращения случайного блуждания)

|

| 8. | Машинное обучение с точки зрения стохастической оптимизации. |

1. Multilevel Monte Carlo

|

| 9. | Распределенная оптимизация. |

1. Методы распределенной оптимизации, использующие сжатие |

| 10. | Математика больших данных в теории информации. |

1. Основные определения теории информации: энтропия и взаимная информация

|

| 11. | Малоранговая аппроксимация матриц. |

1.Скелетное и сингулярное разложения матриц. |

| 12. | Малоранговая аппроксимация тензоров. |

1.Каноническое разложение. |

| 13. | Математика обучения с подкреплением. |

1. Базовые понятия: марковский процесс принятия решений, уравнения Беллмана, онлайн обучение с подкреплением и регрет. Похожее изложение |

4. Методические и оценочные материалы

Задания для практических занятий:

| № п/п |

Наименование раздела дисциплины (модуля) |

Перечень рассматриваемых тем (вопросов) |

| Проект 1. | Reinforcement Learning / AMDP (теоретический). |

В современном обучении с подкреплением в плане теории уже довольно много сделано. Однако для average-reward (AMDP) постановок в теории есть зазор между нижними и верхними оценками. Предлагается в целом изучить RL сквозь призму современной стох. оптимизации (см. в этой связи презентацию, прикрепленную у описанию и цитированную литературу) и сконцентрироваться именно на AMDP. Итогом здесь должно быть написание некоторого небольшого (7-10 страниц) текста-отчета (лучше всего, сделанного в оверлифе), в котором описывается state-of-the-art результаты (теоретические) по AMDP постановкам. Отмечу, что в презентации содержатся не все нужные ссылки (например, нет вот этой), и отчасти работа заключается в поиске таких теоретических работ, в которых есть интересные продвижения. |

| Проект 2. | Поиск вектора Page Rank. |

Изучите статьи Вокруг степенного закона распределения компонент вектора PageRank, Efficient Numerical Methods to Solve Sparse Linear Equations with Application to PageRank (тут есть пример, откуда можно брать данные). Попробуйте реализовать метод MCMC и еще парочку приглянувшихся методов для задачи поиска вектора PageRank. Определите, какой метод и в каком смысле лучше работает. Итогом здесь должен быть colab ноутбук с кодом и хорошими комментариями, поясняющими полученные результаты. |

| Проект 3. | Градиентный клиппинг. |

Посмотрите вот это видео. В различных моделях обучения возникают задачи стохастической оптимизации, в которых у градиентов имеются тяжелые хвосты. Для лучшей практической работы стандартных методов типа SGD и их моментных вариантов используется клиппирование (пробатченного) стохастического градиента. Такой проект мы делали летом 2022 года со школьниками в Сириусе. В результате было сделано следующее (стоит делать поправку, что это делали школьники 8-10 классов): Оказывается, для выпуклых задач есть довольно симпатичная математика, стоящая за всем этим: Near-Optimal High Probability Complexity Bounds for Non-Smooth Stochastic Optimization with Heavy-Tailed Noise, Clipped Stochastic Methods for Variational Inequalities with Heavy-Tailed Noise (совсем идейно это описано в самом начале презентации, прикрепленной к описанию). |

| Проект 4. | Градиентный клиппинг. |

В цикле статей Вершика-Синая-Арнольда исследуются различные предельные формы (например, диаграмм Юнга, выпуклых ломаных и т.п.). Вообще, все это очень красиво, и в своей основе имеет целый ряд фундаментальных законов природы, проявляющихся и в целом ряде других областей. Например, в статистической физике. Для погружения в данную проблематику можно рекомендовать мини-курс А.М. Вершка из трех лекций. Некоторые такие примеры разобраны в книге (см. также цитированную там литературу). Искать можно как раз по фамилиям (Вершик, Синай). Целью данного проекта является разбор того, почему имеет место наблюдение, описанное в скрине. В результате работы над проектом должен появиться текст, обосновывающий результат со скрина. |

| Проект 5. | Как зародилась жизнь? Генетические алгоритмы, Мир РНК. |

Вопрос «как зародилась жизнь?» давно привлекает к себе внимание ученых из разных областей. Текущее понимание этого вопроса изложено в замечательной книге А.А. Маркова «Рождение сложности». Хотя до сих пор нет одной какой-то общепринятой точки зрения, но все же наиболее популярна гипотеза о том, что жизнь могла зародиться из самокопирующихся молекул РНК (гипотеза РНК мира). Обоснование гипотезы требует проработки разных (в том числе чисто математических) вопросов. Замечательно здесь и то, что можно пойти и в обратном направлении (а именно, эволюция/естественный отбор может подсказать способ решения той или иной сложной задачи оптимизации, функционал которой интерпретируется как приспособленность). Собственно, это и предлагается сделать. Решите задачу 16 на стр. 175-176. Требуется математически строго обосновать решение и подкрепить теорию результатами численных экспериментов. |

| Проект 6. | Вокруг методов Монте-Карло, в том числе с приложениями к финансовой математике. |

Посмотрите часть 1 и часть 2 видео «В окрестностях Монте-Карло» и попробуйте на базе прослушанного предложить какие-то свои вариации классических методов. Проект очень неопределенный. Это сделано специально, чтобы дать больше свободы творчества. Также было бы здорово обратить внимание, что для целого ряда вещей совсем не нужна первозданно случайная последовательность. В частности, на практике эффективными оказываются так называемы квази Монте-Карловские методы, под которые есть хорошая теория. Цель данного проекта — знакомство с современными приложениями методов Монте-Карло. В частности, для тех, кто хочет посмотреть в сторону финансовой математике можно рекомендовать в качестве проекта выбрать Multi-level Monte Carlo. А именно, проект заключается в том, чтобы аккуратно обосновать (с нужной теорией и желательно демонстрацией на практике) то, что написано в условиях задачи 22 на стр. 204-205. Для погружения в финансовую математику есть очень доступный курс. |

| Проект 7. | Ранняя остановка или регуляризация. |

Одной из главных проблем машинного обучения является переобучение. Это давно и хорошо известно, и много чего в этой связи было сделано. Если совсем кратко резюмировать, то для задач обучения с выпуклым целевым функционалом (логистическая регрессия, SVM, LASSO, …) основные способы борьбы с переобучением — это регуляризация или ранняя остановка процедур типа SGD. На базе первой главы книги по Алгоритмической стох. оптимизации (ссылка здесь дублируется - имеется в прикрепленном сообщении) попробуйте сделать обзор описанных двух подходов и продемонстрируйте как все это работает на практике. В чем преимущества и недостатки этих двух подходов друг перед другом? Итогом работы по проекту должен стать текст + эксперименты. То есть в этом проекте важны обе составляющие (практическая и теоретическая). |

| Проект 8. | Модели распространения эпидемий, в частности, ковид как модель стохастической химической кинетики. |

Изучите главу 6. В частности, модель Эренфестов, модель хищник-жертва и ее распределенные варианты. Попробуйте на базе похожего формализма получить систему дифференциальных уравнений SIR-типа моделей и предложите свои обобщения. Для дополнительной мотивации можно посмотреть мультфильм. |

| Проект 9. | Почему зависимости частот катастроф от их масштабов имеют степенной закон? |

Изучите задачу Д. Кьялво (задача 12 на стр. 170-171). Попробуйте не только экспериментально проверить то о чем написано в задаче (естественно, в большем масштабе, чем было в эксперименте, который делал Д. Кьялво над своими студентами), но и обосновать это теоретически. Проект также включает в себя текст, с теоретической проработкой, и эксперименты. |

| Проект 10. | Почему большинство крупных мегаполисов живут в режиме пробок, фазовый переход в сетях массового обслуживания. |

Этот проект совершенно реален (то есть идею этого проекта воплотили в жизнь при планировании развития сети общественного транспорта в г. Москве за последние 10-15 лет). Вот краткое описание проблематики (ключевой тут рис. 1). Немного есть про это вот в этом видео (в концовке как раз об этом, впрочем, начало тоже интересное, но не об этом). Речь идет о том, что большинство крупных мегаполисов живут в режимах, когда есть и много пробок. Почему это так? Математическое объяснение есть в книге (см. приложение Малышева-Замятина). Собственно, эта тема дальше развивается в Исследовательской задаче (такой раздел есть в книге) «Задача о критическом числе автомобилей для заданного города». Предложите свой вариант такого типа задачи и получите практическое подтверждение наличия фазового перехода. Проект практический. |

| Проект 11. | Четыре рукопожатия и как это посчитать? |

В замечательной книге Райгородского-Литвак совсем по-простому рассказано о том, как современные социальные сети решают различные задачи подсчета (см. сюжет из Главы 7 Счетчики с короткой памятью и в частности Четыре виртуальных рукопожатия). Попробуйте разобрать пример из статьи Себастьяна Виньи на более продвинутом уровне чем в популярной книге Райгородского-Литвак. В частности, помочь может вот эта книга. Цель проекта продемонстрировать математику, которая есть вокруг этого сюжета (в частности, хеширование). Проект теоретический, но чтобы получить по нему хорошую оценку нужно либо довольно тонко освоить теорию, либо провести достаточно понятные эксперименты, подтверждающие теорию... |

| Проект 12. | Межгрупповая вражда способствует внутригрупповому сотрудничеству. |

В другой интересной книге А.А. Маркова в главе 5 есть параграф, который называется так как этот проект. Прочитайте параграф, постарайтесь понять о чем идет речь. В параграфе описывается некоторое равновесие макросистемы. Попробуйте придумать каку-то разумную динамику, которая бы приводила к такому равновесию (соответствующие заготовки могут быть почерпнуты из 6 главы книги). Нужно не только придумать, подтвердить экспериментально, но и попробовать математически обосновать, что предложенная динамика, действительно, выходит на нужное равновесие… P.S. В целом, очень рекомендую эту книгу Маркова, если есть желание получше разобраться как устроены люди. Кажется, в этой книге есть и много других интересных сюжетов (например, парадокс Симпсона, теория Гамильтона — родственного отбора, и многое другое), которые, по-видимому, качественно улавливают какие-то закономерности, управляющие поведением людей. По итогам этого проекта появилась статья. |

| Проект 13. | Кинетика социального неравенства. |

Решите задачу 4 на стр. 154-162. Решение требуется привести математическое. Это один вариант сдачи проекта. Второй вариант — предложить свои вариации модели обмена монетками, которые приводят к более интересным асимптотикам. В этом случае обоснование формы предельных кривых может быть схематичным, но желательно тогда подтверждение численными экспериментами. |

| Проект 14. | Двойной спуск, сложный проект! |

В последние годы в задачах обучения наблюдается довольно интересный эффект, что если модель сильно переобучена, то U-образная кривая снова начинает убывать. Математика этого эффекта еще далека от своего окончательного объяснения, но все же попытки это объяснить имеются. В том числе довольно компактные. Более того, все эти вопросы оказываются завязанными на так называемое условие Поляка-Лоясиевича (градиентного доминирования). К сожалению, на данный момент неизвестны нижние оценки для гладких задач оптимизации в условиях Поляка-Лоясиевича. При том, что много интересных результатов о сходимости градиентного типа методов (в том числе и их стохастических вариантов) есть. Проект, по-видимому, достаточно сложный. Целью проекта является продвинуться в понимание, какие нижние оценки имеют место для методов типа градиентного спуска в условиях Поляка-Лоясиевича. Гипотеза, что имеющиеся верхние оценки оптимальны. То есть ускорения в условиях Поляка-Лоясиевича нет. Проблема тут с использованием стандартной техники получения нижних оценок упражнения 1.3 и 2.1. Нужно найти подобную плохую функцию, удовлетворяющую условию Поляка-Лоясиевича. Ну или как-то еще посмотреть на эту задачу. |

| Проект 15. | Гамильтоновы пути и концентрация меры. |

Хорошо известно, что задача поиска гамильтонова пути — NP-трудна. А именно, трудной является задача почтальона: в каком порядке надо обойти дома на своем участке и вернуться в отделение почты (откуда и стартует маршрут), чтобы суммарная длина пути была бы минимальна? Конечно, метрический коммивояжер уже немного попроще (веса ребер графа отвечают некоторой топологии реальной дорожной сети, скажем на плоскости), чем общая задача. Все равно эта задача остается сложной и улучшается у нее только различные аппроксимационные характеристики. Представим себе, что теперь у нас город — это квадрат со стороной 1. В городе n домов. Все дома случайно и независимо построены (дом - это точка в квадрате, обе координаты которой выбираются независимо и из равномерного распределения). Обозначим длину кратчайшего (гамильтонового) пути в таком графе через TSP(n). Это будет случайная величина. Покажите, что TSP(n) экспоненциально концентрируется около своего математического ожидания, пропорционального \sqrt{n}. Указание: Используйте книгу. |

| Проект 16. | Устойчивые системы большой размерности. | |

| Проект 17. | О типично худшем накоплении ошибки в линейных итерационных методах. |

Попробуйте решить задачу |

| Проект 17 от Максима Рахубы. | Использование тензорных сетей для сжатия и восстановления изображений. |

В этом проекте предлагается познакомиться с тензорными сетями (обобщение матричных факторизаций на многомерный случай и их приложением для задач восстановления изображения по значениям в небольшом числе пикселей (tensor completion), а также для сжатия изображений. Для конкретики можно рассмотреть тензорные сети PEPS, тензорное кольцо и/или тензорный поезд. Для решения задач минимизации можете использовать несколько методов оптимизации на свой выбор, а также реализовать метод попеременных наименьших квадратов (ALS) (только для задачи сжатия). Для более детального ознакомления с постановкой задачи и одним из возможных алгоритмов прочитайте статью и ознакомьтесь с сайтом. В качестве фреймворка для написания проекта можно воспользоваться пакетом или альтернативными вариантами. Результатом работы по проекту должна стать jupyter тетрадка (можно ссылкой в colab), с кодом, кратким описанием используемых алгоритмов, а также графиками ошибки и значений PSNR от числа параметров в тензорных сетях для нескольких изображений. |

| Проект 18 от Максима Рахубы. | Методы римановой оптимизации и их приложение для рекомендательных систем. |

Известно, что множество матриц фиксированного ранга является римановым многообразием. Эту информацию можно использовать для построения эффективных методов поиска малоранговых приближений матриц. В этом проекте предлагается познакомиться с методами римановой оптимизации, реализовать риманов метод сопряженных градиентов, а также воспользоваться им для минимизации l1 нормы ошибки. В качестве приложения предлагается построить рекомендательную систему. Результатом работы по проекту должна стать jupyter тетрадка (можно ссылкой в colab), с кодом, кратким описанием используемых алгоритмов, а также графиками зависимости RMSE и одной из релевантных для рекомендательных систем метрик в зависимости от ранга. По поводу вопросов пишите в ТГ @mrakhuba. |

| Проект 19 от Алексея Фролова. | Граница случайного кодирования для задачи сжатия измерений массового некоординированного множественного доступа. |

В работе [1] введена теоретико-информационная модель массового некоординированного множественного доступа и получена граница случайного кодирования, которую можно применять как в асимптотическом, так и неасимптотическом режимах. Улучшение для асимптотического режима предложено в работе [2] с использованием леммы Гордона (Gordon’s lemma) о минимуме гауссовского процесса. Задача данного проекта заключается в получении неасимптотической версии границы из [2]. Также разрешается применять любые другие методы уточнения аддитивной границы из [1], например, предложенную на лекции локальную лемму Ловаша. |

Контрольные вопросы для подготовки к промежуточной аттестации:

Для ознакомления доступна контрольная работа

Перечень учебно-методического обеспечения дисциплины

Список основной литературы:

1. Blum A., Hopcroft J., Kannan R. Foundations of data science. – Cambridge University Press, 2020.

2. Bach F. Learning Theory from First Principles. – 2021.

3. Тыртышников Е. Е. Методы численного анализа. – 2007.

4. Зорич В. Математический анализ задач естествознания. – Litres, 2018.

Список дополнительной литературы:

1. Гyдфеллоy Я., Бенджио И., Кyрвилль А. Глyбокое обyчение. 2-е изд., исправл. М.: ДМК-Пресс, 2018.

2. Shapiro A., Dentcheva D., Ruszczyński A. Lectures on stochastic programming: modeling and theory. – Society for Industrial and Applied Mathematics, 2014.

3. Shalev-Shwartz S., Ben-David S. Understanding machine learning: From theory to algorithms. – Cambridge university press, 2014.

4. Bubeck S. Convex optimization: Algorithms and complexity // Foundations and Trends® in Machine Learning Volume 8 Issue 3-411 pp 231–357. – 2015.

5. Duchi J. C. Introductory lectures on stochastic optimization // The mathematics of data. – 2018. – V. 25. – P. 99-185.

6. Hazan E. Lecture notes: Optimization for machine learning // arXiv preprint arXiv:1909.03550. – 2019.

7. Lan G. First-order and Stochastic Optimization Methods for Machine Learning. – Springer Nature, 2020.

8. Milman V. D. The heritage of P. Lévy in geometrical functional analysis //Astérisque. – 1988. – Т. 157. – №. 158. – С. 273-301.

9. Shen A., Romashchenko A., Rumyantsev A. Y. Заметки по теории кодирования. – 2017.

10. Vershynin R. High-dimensional probability: An introduction with applications in data science. – Cambridge university press, 2018. – Т. 47.

Методические указания для обучающихся по освоению дисциплины

| Вид учебных занятий/деятельности |

Деятельность обучающегося |

| Лекция | Написание конспекта лекций: кратко, схематично, последовательно фиксировать основные положения лекции, выводы, формулировки, обобщения; помечать важные мысли, выделять ключевые слова, термины. Обозначить вопросы, термины или другой материал, который вызывает трудности, пометить и попытаться найти ответ в рекомендуемой литературе. Если самостоятельно не удается разобраться в материале, необходимо сформулировать вопрос и задать преподавателю на консультации, во время семинарского (практического) занятия. |

| Подготовка к промежуточной аттестации | При подготовке к промежуточной аттестации необходимо проработать вопросы по темам, которые рекомендуются для самостоятельной подготовки. При возникновении затруднений с ответами следует ориентироваться на конспекты лекций, семинаров, рекомендуемую литературу, материалы электронных и информационных справочных ресурсов, статей. Если тема вызывает затруднение, четко сформулировать проблемный вопрос и задать его преподавателю. |

| Контрольная работа | При подготовке к контрольной работе необходимо проработать материалы лекций, семинаров, основной и дополнительной литературы по заданной теме. |

| Выполнение домашних заданий и групповых проектов | Для выполнения домашних заданий и групповых проектов необходимо получить формулировку задания от преподавателя и убедиться в понимании задания. При выполнение домашних заданий и групповых проектов необходимо проработать материалы лекций, основной и дополнительной литературы по заданной теме. |

Методы и технологии обучения, способствующие формированию компетенции

| Методы и технологии обучения, способствующие формированию компетенции |

| В курсе планируется использовать несколько технологий обучения. Таких как: интерактивные лекции , поощряющие участие студентов посредством сессий вопросов и ответов или групповых дискуссий.

Проблемно-ориентированное обучение – мероприятия по решению проблем, которые побуждают студентов применять концепции курса в практических ситуациях. Этот метод может улучшить навыки критического мышления и закрепления знаний.

Важный элемент курса – смешанное обучение : сочетание традиционного очного обучения с онлайн-учебными ресурсами, такими как видео, симуляторы или интерактивные викторины. Такой подход может учитывать различные стили обучения и предпочтения, одновременно улучшая понимание учащимися концепций курса. |